Trong thời đại dữ liệu trở thành “tài sản quý giá” của doanh nghiệp, việc hiểu và khai thác dữ liệu đúng cách không chỉ giúp tiết kiệm chi phí mà còn mở ra lợi thế cạnh tranh vượt trội. Phân tích dữ liệu (Data Analysis) chính là chìa khóa giúp chuyển đổi những con số khô khan thành các insight giá trị, hỗ trợ nhà quản trị ra quyết định chính xác, nhanh chóng và hiệu quả. Bài viết dưới đây sẽ giúp bạn hiểu rõ khái niệm, các loại hình, quy trình cũng như công cụ phổ biến trong phân tích dữ liệu hiện nay.

Tầm quan trọng của phân tích dữ liệu

1. Phân tích dữ liệu là gì?

Phân tích dữ liệu là quá trình thu thập, xử lý và diễn giải dữ liệu để rút ra những thông tin có giá trị phục vụ cho việc ra quyết định. Quá trình này giúp chuyển đổi dữ liệu thô thành các hiểu biết sâu sắc về xu hướng, hành vi và hiệu quả hoạt động. Nhờ phân tích dữ liệu, doanh nghiệp có thể dự đoán nhu cầu, tối ưu hóa quy trình và xây dựng chiến lược phát triển dựa trên cơ sở khoa học.

>> Đọc thêm: Cách Tính Hiệp Phương Sai Trong Kinh Tế Lượng Từ A – Z Kèm Ví dụ Chi Tiết

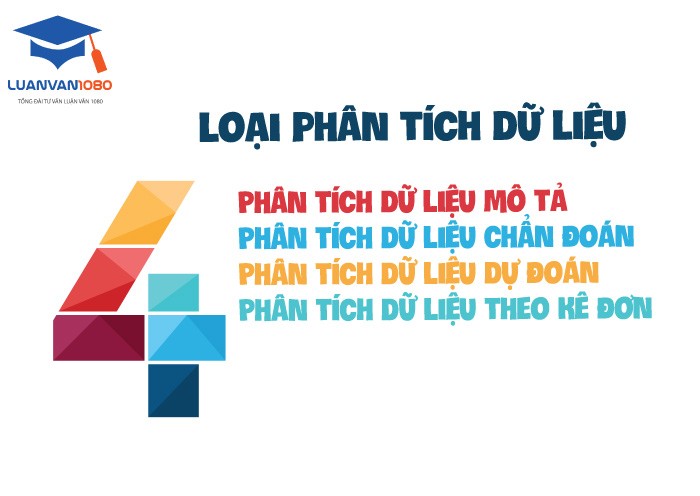

2. Các loại hình phân tích dữ liệu

Phân tích dữ liệu được chia thành nhiều loại khác nhau tùy theo mục tiêu và mức độ phức tạp của quá trình xử lý thông tin. 4 loại hình phổ biến gồm:

4 loại phân tích dữ liệu

- Phân tích mô tả: Tập trung vào việc tổng hợp dữ liệu quá khứ để hiểu rõ “điều gì đã xảy ra”. Các kỹ thuật thống kê được sử dụng để tạo báo cáo, bảng biểu, biểu đồ mô tả xu hướng hoặc biến động theo thời gian.

- Phân tích chẩn đoán: Giúp trả lời câu hỏi “tại sao sự việc xảy ra”. Bằng cách so sánh, đối chiếu và phân tích mối tương quan giữa các yếu tố, doanh nghiệp có thể xác định nguyên nhân dẫn đến kết quả hoặc sự cố.

- Phân tích khám phá: Dùng để khám phá cấu trúc dữ liệu, phát hiện mối liên hệ tiềm ẩn hoặc điểm bất thường. Đây là giai đoạn trung gian quan trọng trước khi xây dựng mô hình dự đoán.

- Phân tích dự đoán: Sử dụng thuật toán thống kê và học máy để dự báo kết quả tương lai. Ví dụ, dự đoán nhu cầu thị trường, hành vi khách hàng hoặc rủi ro kinh doanh.

- Phân tích đề xuất: Nâng tầm dự đoán bằng cách đưa ra giải pháp hành động tối ưu. Các mô hình toán học, mô phỏng và tối ưu hóa được sử dụng để gợi ý phương án hiệu quả nhất cho từng tình huống.

>> Tham khảo thêm: Dịch vụ thuê làm luận văn đa dạng gói lựa chọn cho học viên

3. Các kỹ thuật và phương pháp phân tích dữ liệu

Các kỹ thuật phân tích dữ liệu đóng vai trò như nền tảng để trích xuất giá trị từ thông tin. Một số kỹ thuật phổ biến gồm:

3.1. Phân tích hồi quy

Xác định mối quan hệ giữa các biến độc lập và biến phụ thuộc, thường dùng để dự đoán kết quả định lượng như doanh thu hoặc chi phí.

3.2. Phân tích nhân tố

Tìm ra các nhân tố tiềm ẩn ảnh hưởng đến dữ liệu, giúp giảm số chiều và đơn giản hóa mô hình phân tích.

3.3. Phân tích chuỗi thời gian

Nghiên cứu sự thay đổi của dữ liệu theo thời gian nhằm nhận diện xu hướng, mùa vụ hoặc mô hình biến động.

3.4. Thống kê mô tả và suy luận

- Thống kê mô tả giúp tóm tắt dữ liệu bằng các chỉ số như trung bình, độ lệch chuẩn.

- Thống kê suy luận cho phép rút ra kết luận hoặc dự đoán cho toàn bộ tổng thể dựa trên dữ liệu mẫu.

3.5. Phân tích cụm và phân loại

- Phân tích cụm nhóm các đối tượng có đặc điểm tương đồng.

- Phân tích phân loại gán dữ liệu mới vào các nhóm đã biết dựa trên mô hình học máy.

3.6. Phân tích thành phần chính

Giảm bớt số lượng biến nhưng vẫn giữ lại phần lớn thông tin, giúp dữ liệu dễ hình dung và xử lý hơn.

3.7. Phát hiện bất thường

Xác định các điểm dữ liệu khác biệt so với phần còn lại, thường dùng trong kiểm soát rủi ro, an ninh mạng hoặc phát hiện gian lận.

3.8. Khai phá dữ liệu

Tìm ra các mẫu, quy luật ẩn trong tập dữ liệu lớn bằng các kỹ thuật thống kê và học máy.

3.9. Học máy và học sâu

Ứng dụng thuật toán để tự động phát hiện mô hình, đưa ra dự đoán hoặc đề xuất mà không cần lập trình chi tiết.

3.10. Phân tích dữ liệu không gian

Phân tích dữ liệu có yếu tố vị trí, hỗ trợ ra quyết định trong logistics, quy hoạch đô thị hoặc giám sát môi trường.

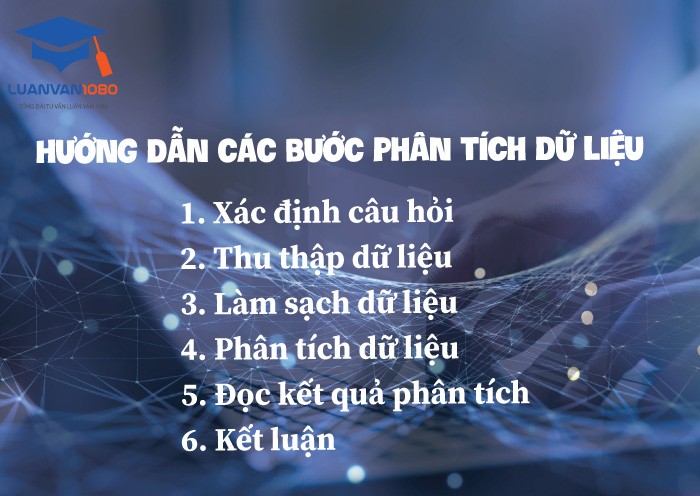

4. Quy trình các bước phân tích dữ liệu

Hướng dẫn các bước phân tích dữ liệu

Quy trình phân tích dữ liệu gồm các bước liên kết chặt chẽ, đảm bảo tính khoa học và hiệu quả của toàn bộ quá trình:

- Xác định vấn đề hoặc mục tiêu phân tích: Là bước khởi đầu quan trọng, giúp xác định rõ câu hỏi cần trả lời và hướng đi của quá trình phân tích.

- Thu thập dữ liệu: Dữ liệu được lấy từ nhiều nguồn: cơ sở dữ liệu nội bộ, khảo sát, mạng xã hội, hoặc các hệ thống cảm biến. Việc chọn đúng nguồn quyết định độ chính xác của kết quả.

- Xử lý và làm sạch dữ liệu: Loại bỏ dữ liệu lỗi, trùng lặp, sai định dạng hoặc thiếu giá trị. Quá trình chuẩn hóa giúp đảm bảo dữ liệu nhất quán và sẵn sàng cho phân tích.

- Khám phá và phân tích dữ liệu: Ứng dụng các phương pháp thống kê, học máy, hoặc mô hình toán học để tìm ra mẫu, mối quan hệ và xu hướng.

- Trực quan hóa và trình bày kết quả: Sử dụng biểu đồ, đồ thị, bản đồ nhiệt hoặc dashboard để thể hiện dữ liệu một cách trực quan, giúp người ra quyết định dễ dàng hiểu và hành động.

- Đưa ra kết luận và đề xuất hành động: Tổng hợp kết quả, rút ra insight chính và đề xuất giải pháp hoặc chiến lược dựa trên dữ liệu.

5. Các công cụ hỗ trợ phân tích dữ liệu

Công cụ đóng vai trò quan trọng trong việc triển khai và tự động hóa quy trình phân tích. Một số công cụ phổ biến bao gồm:

Các công cụ phân tích dữ liệu

- Power BI: Công cụ trực quan hóa mạnh mẽ của Microsoft, cho phép kết nối nhiều nguồn dữ liệu, tạo dashboard tương tác và chia sẻ báo cáo nội bộ nhanh chóng.

- Excel: Phần mềm phổ biến hỗ trợ tính toán, thống kê, lọc dữ liệu, tạo biểu đồ và phân tích cơ bản qua PivotTable hoặc hàm nâng cao.

- Python: Ngôn ngữ lập trình linh hoạt với các thư viện như Pandas, NumPy, Matplotlib, Scikit-learn giúp xử lý, phân tích và trực quan hóa dữ liệu ở quy mô lớn.

- Zoho Analytics: Nền tảng báo cáo trực tuyến giúp kết nối, tổng hợp và trực quan hóa dữ liệu từ nhiều hệ thống khác nhau.

- Tableau: Công cụ BI mạnh, cho phép kéo-thả để tạo biểu đồ và bảng điều khiển, giúp người dùng không cần biết lập trình vẫn có thể phân tích chuyên sâu.

- Amazon Redshift và các nền tảng dữ liệu đám mây: Dành cho doanh nghiệp lớn cần xử lý khối lượng dữ liệu khổng lồ, hỗ trợ truy vấn nhanh, phân tích song song và mở rộng linh hoạt.

Phân tích dữ liệu không chỉ là một kỹ năng, mà còn là nền tảng của mọi chiến lược kinh doanh hiện đại. Khi doanh nghiệp biết tận dụng sức mạnh của dữ liệu, họ có thể dự đoán xu hướng, tối ưu hoạt động và ra quyết định dựa trên bằng chứng thay vì cảm tính. Dù bạn là sinh viên, nhà nghiên cứu hay nhà quản lý, việc nắm vững kiến thức và công cụ phân tích dữ liệu sẽ là hành trang vững chắc trên con đường phát triển nghề nghiệp trong kỷ nguyên số.

14 Tháng 1, 2026

14 Tháng 1, 2026 Share

Share